Длинный пост про то, как достичь успеха! Бесплатно! без регистрации и смс! Я тут просто наткнулся на одну научную работу, которая доказывает, что роль случая в успехе выше, чем роль таланта. И это срезонировало с моим убеждением, что все успешные люди успешные, потому что им повезло, а не потому что они какие-то необыкновенно талантливые, умные, или необычные. Скорее даже наоборот, они такие, потому что им повезло. Заметьте, не потому что они «везунчики», а потому что им повезло. Это разные вещи.

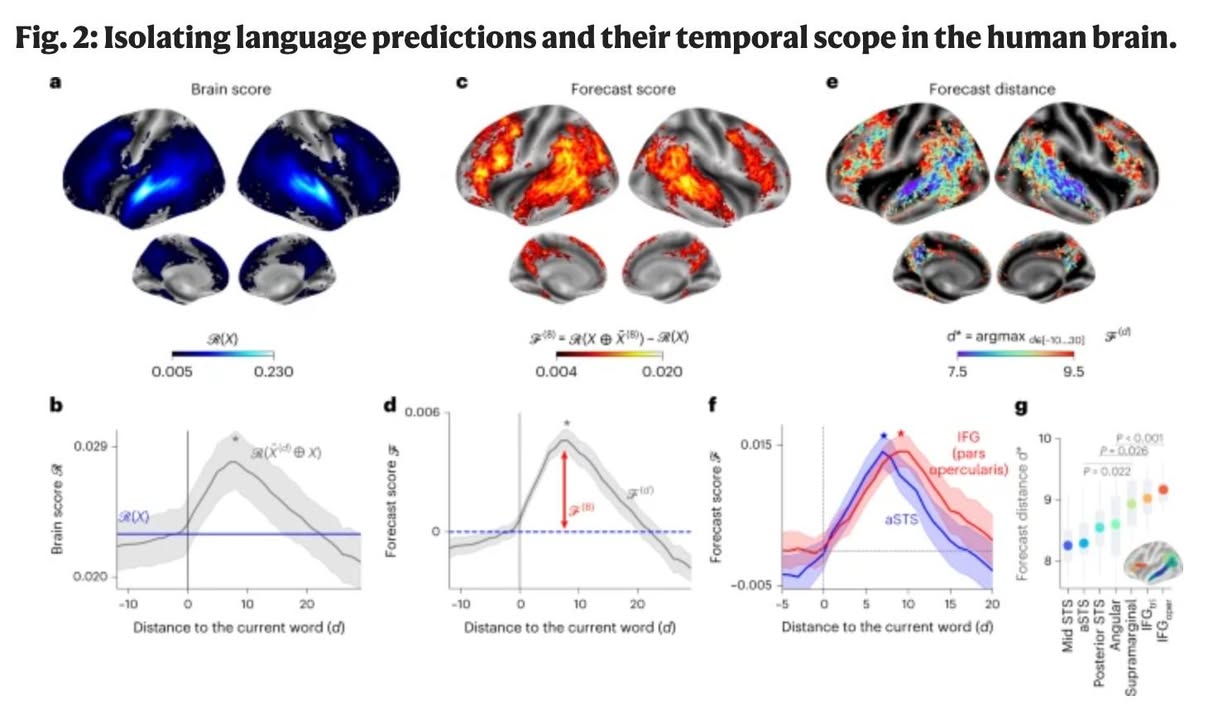

Аргументирую. Есть исследование «Talent vs Luck: the role of randomness in success and failure», авторы Алессандро Плучино, Алессио Эмануэле Биондо и Андреа Рапизарда. Да, ржач в том, что Алессандро за эту работу получил Шнобелевскую премию («символическая награда за научные открытия, «сначала заставившие людей смеяться, а затем задуматься»»). Они использовали агентное моделирование для анализа вклада таланта и удачи в успех.

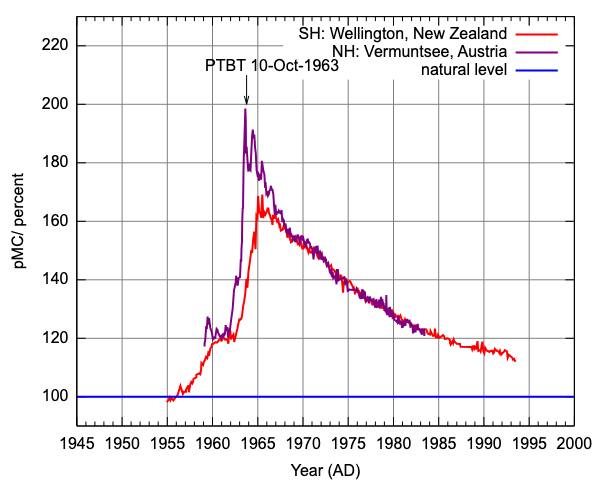

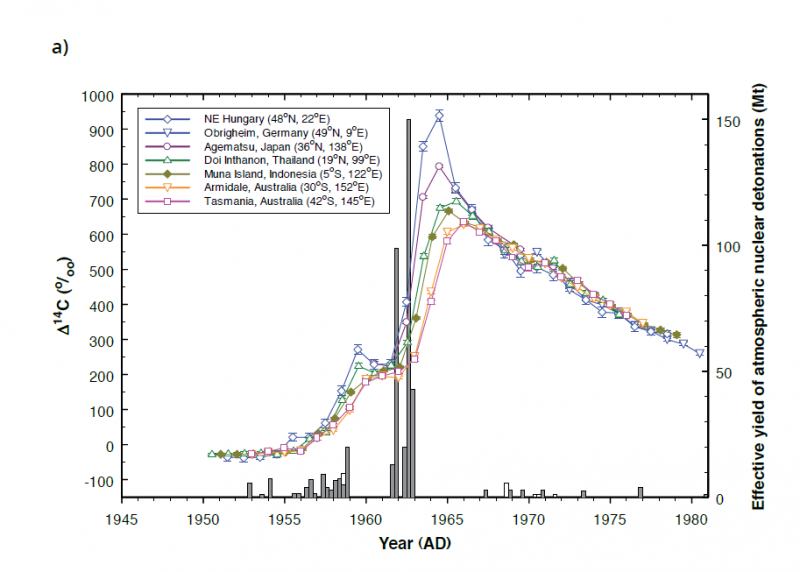

За исходные данные они взяли вроде как объективные вещи: талант и интеллект распределены среди населения по нормальному (гауссовскому) закону, где большинство людей имеют средний уровень этих качеств, а крайние значения встречаются редко, а богатство, часто рассматриваемое как показатель успеха, следует закону распределения Парето (степенному закону), при котором небольшое число людей владеет значительной частью ресурсов, а большинство — лишь малой долей.

Далее авторы разработали простую модель, в которой агенты (1000) с различным уровнем таланта подвергаются в течение условных 40 лет случайным событиям, которые могут быть как благоприятными (удача), так и неблагоприятными (неудача). Каждое такое событие влияет на «капитал» агента, служащий мерой его успеха.

Результат: Хотя определенный уровень таланта необходим для достижения успеха, наиболее успешными часто становятся не самые талантливые индивиды, а те, кто обладает средним уровнем таланта, но испытывает больше удачных событий. Существует сильная корреляция между количеством удачных событий и уровнем успеха: самые успешные агенты являются и самыми удачливыми.

Мое наблюдение за тем, «как работает мир», полностью с этими выводами согласуется. Нужно просто делать так, чтобы тебе больше везло. Всё. Не надо стараться быть самым умным — это не помогает настолько, насколько помогают следующие вещи:

1) Быть в среде, где случаются важные события. Кремниевая долина для стартаперов. Нью-Йорк для финансистов. Голливуд для актеров. Если окружение повышает вероятность знакомства с «ключевыми» людьми, то логично поместить себя в это окружение.

2) Создавать больше точек касания с миром и поддерживать их. Вести блог, писать статьи, давать интервью. Ходить на конференции, участвовать в сообществах. Звонить и писать знакомым и полузнакомым, особенно, когда такие звонки и письма им потенциально важны. Расширять количество контактов – даже если 99% бесполезны, 1% может изменить жизнь.

3) Увеличивать количество попыток. Чем больше проектов, тем выше шанс, что один из них «выстрелит». Лучший пример – венчурные фонды: они инвестируют в десятки стартапов, зная, что успех принесет лишь один. Художники, писатели, музыканты создают сотни работ, зная, что только одна станет хитом.

К сожалению, для этого пункта надо любить свое дело. Поэтому выбирайте такое дело, где попытки делать приятно.

Организационный психолог Томас Чаморро-Премузик в своей книге «Why Do So Many Incompetent Men Become Leaders?» утверждает, что удача составляет около 55% успеха, включая такие факторы, как место рождения и семейное благосостояние. Это так, но раз вы сидите в фейсбуке на айфончике за чашкой кофе, а не гоняете коров в набедренной повязке в Африке, у вас уже неплохие начальные условия.

Отсюда интересный вывод — нужно ли учиться в университете, чтобы тебя настиг успех в жизни? Смотрим на пункты выше. Быть в среде, создавать больше точек касания, увеличивать число попыток. Из этих трех пунктов два работают лучше в случае очного обучения, а третий работает не очень, потому что университет съедает 4-5 лет жизни (и университет — это одна попытка). Но зато два других критерия очень важны — за время обучения средний студент общается с сотнями сверстников, которые могут оказать существенный вклад в вероятность успеха этого студента.

Но вот сидеть эти пять лет дома с книжками — не соответствует ни одному критерию. Онлайн-образование находится где-то между, смотрите сами, оно разное бывает, но ближе к варианту «сидеть с учебниками».

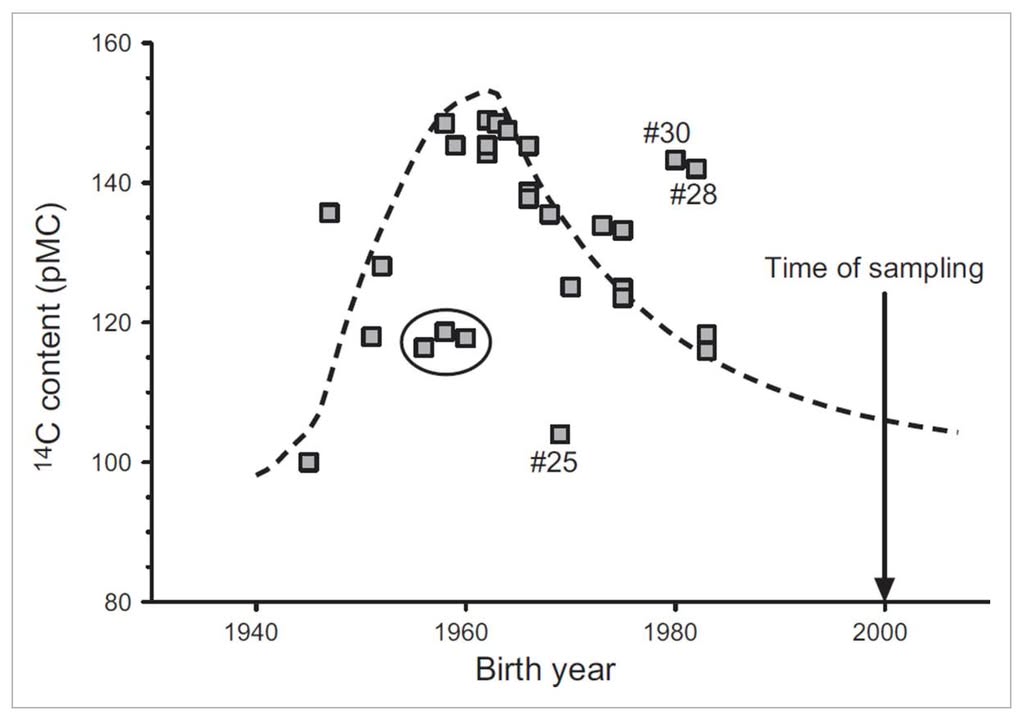

Авторы исследования подтвердили концепцию «Эффекта Матфея». Это из Библии: «Ибо всякому имеющему дано будет, и приумножится; а у не имеющего отнимется и то, что имеет.» (Евангелие от Матфея, 25:29). Объясняют, почему успех накапливается, даже если он изначально случаен:

Люди, которым повезло на ранних этапах, получают больше ресурсов, возможностей и внимания. Это, в свою очередь, увеличивает их шансы на новые удачные события. В результате те, кто изначально оказался в выгодном положении, продолжают наращивать успех, а остальные остаются позади.

Это объясняет, почему богатые люди чаще получают выгодные инвестиции, популярные артисты становятся ещё популярнее, а менее известные остаются в тени, а компании, которые «попали в струю», привлекают больше клиентов и ресурсов, чем их менее удачливые конкуренты.

Именно поэтому для успеха еще нужно следовать принципу «Fake it till you make it». Успешный человек чаще преувеличивает свои навыки или достижения, а затем подтягивается до заявленного уровня. Общество такие штуки почему-то легко прощает и быстро забывает, но когда они срабатывают (а срабатывают часто), то человек уже в них особо не нуждается. Есть еще self-fulfilling prophecy — самореализующееся пророчество. Идея в том, что если человек заявляет что-то как факт (даже если это преувеличение), он и окружающие начинают вести себя так, будто это правда, и в итоге это действительно становится реальностью.

Есть еще принцип «за спрос денег не берут» (It doesn’t hurt to ask). Принцип в том, что если вероятность успеха поднимает заданный кому-то вопрос («а можете поднять мне зарплату с марта или включить главным вон в тот проект»), то надо спрашивать. You never know unless you ask.

И еще кое-что. Act now, apologize later. Actions speak louder than words. Как вы знаете, быть в нужное время в нужном месте имеет не только нужное место (это первый пункт из моего списка), но и нужное время. Поэтому just do it. Из людей, которые не мечтают, а делают, никогда никто не заканчивает бомжом на улице, потому что поторопился.

И последнее. Время — конечный ресурс. Хорошая идея была про листочек с клеточками — гуглите «90 лет жизни в неделях». Можно закрасить прожитые и посмотреть на оставшиеся.

Итак, резюмирую.

Успех определяется удачей, а не талантом. Талант помогает, но чаще формируется под влиянием успеха. Знания полезны, но опыт полезнее. Время — конечный ресурс. Планирование не работает, работают три вещи:

1) быть в среде, где случаются важные события,

2) создавать больше точек касания с миром и поддерживать их,

3) увеличивать количество попыток, где может сработать удача.

Три принципа:

1) Fake it till you make it

2) It doesn’t hurt to ask

3) Actions speak louder than words