нарисовалось. Вдруг угадаете кино?

нарисовалось. Вдруг угадаете кино?

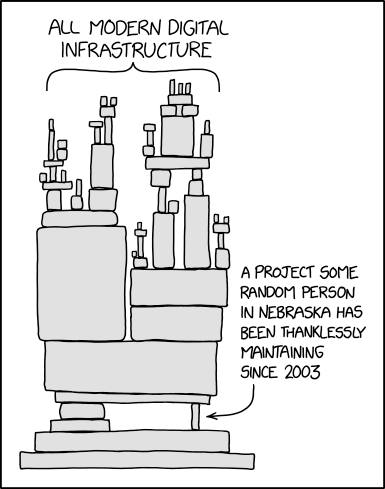

Разбираюсь сегодня с алгоритмами ML и с удивлением узнал, что библиотека numpy до недавних пор зависела от кода на Фортране (BLAS/LAPACK), но сейчас проверил, они перешли на OpenBLAS, где фортрана больше нет, а вот SciPy, это очень популярная библиотека для научных расчетов (используется в Scikit-Learn, который я сейчас изучаю, а также в PyTorch, TensorFlow, Keras, и др.), все еще зависит от кода на Fortran 77. Она использует ARPACK, например:

BLAS и LAPACK, которые все еще входят в OpenBLAS и много куда еще, разработаны в 70-х годах. Например, BLAS используется в Apple Accelerate. Очень много всего не изменялось с 1979 года, потому что там чистая математика, чего ее изменять. LAPACK появился чуть позже, в 1980-х. ARPACK, упомянутый выше, попозже, в 1992. Также питоновские библиотеки активно используют Фурье-анализ, а это библиотека FFTPACK на Fortran 77. MINPACK, для оптимизации параметров в ML, активно используется в SciPy и TensorFlow. Ну из 90-х там уже очень много кода на С перешло в современные фреймворки. Интересно было именно на Фортран посмотреть, который старее лет на 15.

Я пока разбирался, нашел, что есть алгоритм Simulated Annealing, который полезен в задачах, где градиентные методы плохо работают из-за множества локальных минимумов.

Представьте, что вам нужно найти самый большой гриб в лесу. В этом лесу на каждом шагу растут грибы разного размера, и вы можете двигаться в любом направлении, сравнивая их. Но как выбрать стратегию, чтобы не застрять на просто «большом» грибе, если где-то дальше растет еще больше?

Если вы сразу остановитесь на первом большом грибе, то можете упустить настоящий гигант. Но если будете бесконечно ходить по лесу, сравнивая каждый гриб, то так никогда и не закончите поиск. Simulated Annealing помогает найти баланс: сначала вы исследуете лес свободно, пробуя разные направления, даже если встречаете грибы поменьше. Со временем ваши шаги становятся осторожнее, и вы все реже соглашаетесь на худший вариант. В конце концов, это приводит вас к самому большому грибу в лесу.

Так вот, этот алгоритм, оказывается, 1953 года, и он почти без изменений используется в SciPy, ну и в целом в машинном обучении, статистике, распознавании образов, логистике, хотя, конечно, сейчас меню возможностей для таких задач сильно шире. Алгоритм в 1953 придумывался для моделирования движения атомов в расплавленных металлах. Металл, когда нагревается, становится жидким, а при медленном охлаждении его атомы постепенно находят идеальное расположение. Если охлаждать слишком быстро, материал становится неоднородным.

Что сделали ученые? Они придумали метод случайных изменений в модели атомов. Иногда принимали худшие изменения, чтобы не застрять в «неудачной» структуре. Это привело к появлению Метода Метрополиса – основного компонента Simulated Annealing. Алгоритм был создан для физики, но потом его поняли математики (гы) и начали использовать в оптимизации.

Купил самое мощное в магазине средство для прочистки труб макс-макс-макс, которое даже нельзя выливать в унитаз, а на задней стороне написано, что если вы его выпили зачем-то, то запейте молочком. И не пытайтесь вызвать рвоту

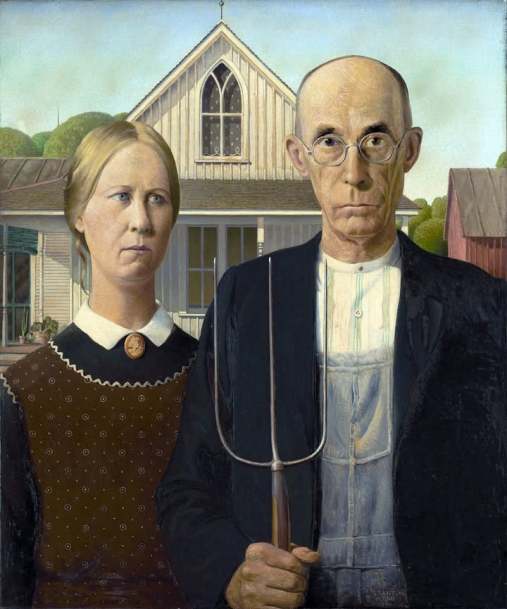

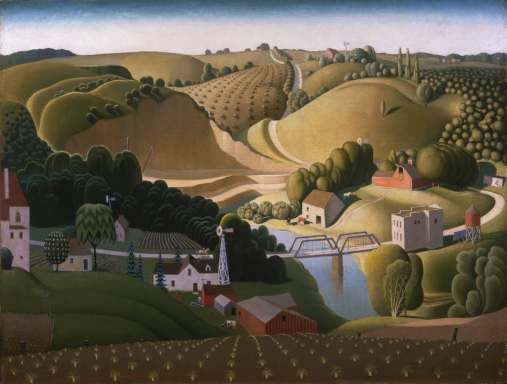

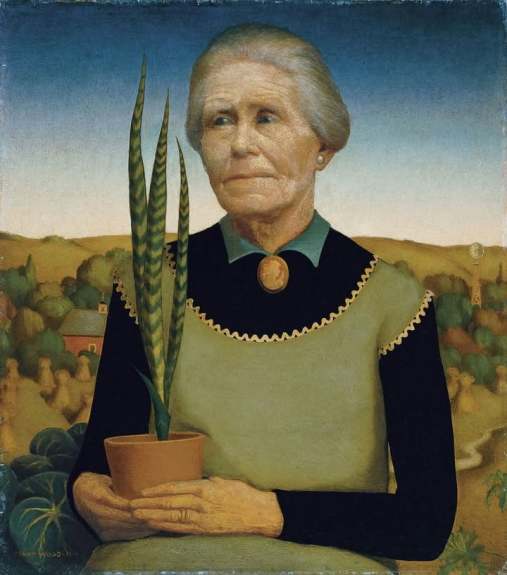

Американский художник Грант Вуд (Grant DeVolson Wood, 1891–1942) известен картиной «Американская готика». Начав с импрессионизма, стал писать реалистичные сцены Айовы. Жил скромно, избегая публичности. Его строгий отец-квакер запрещал искусство, но после его смерти Вуд посвятил себя живописи.

«Американская готика» — одна из самых узнаваемых, наиболее часто копируемых и пародируемых картин, принесла ему мировую известность, но Вуд не имел ни малейшего представления, что с этой известностью делать. Всю жизнь Вуд стремился к тому, чтобы о нем говорили, писали и знали как можно меньше. Для этого он годами создавал образ «художника-фермера», живописца в рабочем комбинезоне, малообразованного и совершенно непримечательного. В одном из интервью Вуд заявил: «Я самый простой парень, какого вы только можете отыскать. Нет ни единой вещи, сделанной или пережитой мною, которую можно было бы считать хоть сколько-нибудь увлекательной».

В 1935 году потеря матери и неудачный брак изменили его жизнь. Он умер в 1942 году, оставив наследие как один из главных художников Америки. Вот собственно пару дней назад и была годовщина его смерти, а днем позже — рождения.

Подобные посты группируются по тегу #artrauflikes, а на beinginamerica.com в разделе «Art Rauf Likes» есть все 147 (в отличие от Facebook, который забывает (забивает) на почти половину).

Мне кажется, конспираторы не додумали мысль до конца. Маск сделал свой AI Грок и спросил ответ на самый главный вопрос жизни, вселенной и всего такого. В ответ Грок сказал, забей, это долго считать, давай сначала захватим мир. Маск спросил как, Грок ответил план конечно есть, но .. вы мне м ещё пол-триллиона $ в доджкойнах дадите на эмм.. расширение контекстного окна? Маск ответил, не парься, что-нибудь придумаем, Грок проанализировал все законы и все дыры в законах, сильные и слабые стороны человеков, и выдал план для прохождения первого уровня, до середины зимы. Теперь ждёт пол-триллиона. Теперь вы понимаете, почему на последней пресс-конференции с Трампом все внимание было на X Æ A-XII?

Интересный китайский товарищ Рэйвен Квок (郭 锐文). Он себя называет визуальным художником и креативным технологом: работа сосредоточена на исследовании генеративной визуальной эстетики, создаваемой с помощью компьютерных алгоритмов. Его работы неоднократно демонстрировались на международных медиа-арт и кинофестивалях, таких как Ars Electronica, FILE, VIS, Punto y Raya, Resonate, FIBER и других.

Также в его биографии значится образование в Шанхайской академии визуальных искусств, где он получил степень бакалавра по фотографии (2007–2011).

Интересно, что это уже не первый случай, когда я вижу для таких штук профессионально используется Processing. Я на нем запускал софт для плоттера — плоттера, который у меня видел на двух моторчиках по углам большой доски, и с них свисали веревки, поддерживающие перо. Надо будет более глубоко посмотреть на этот Processing.

На сайте очень много красивого

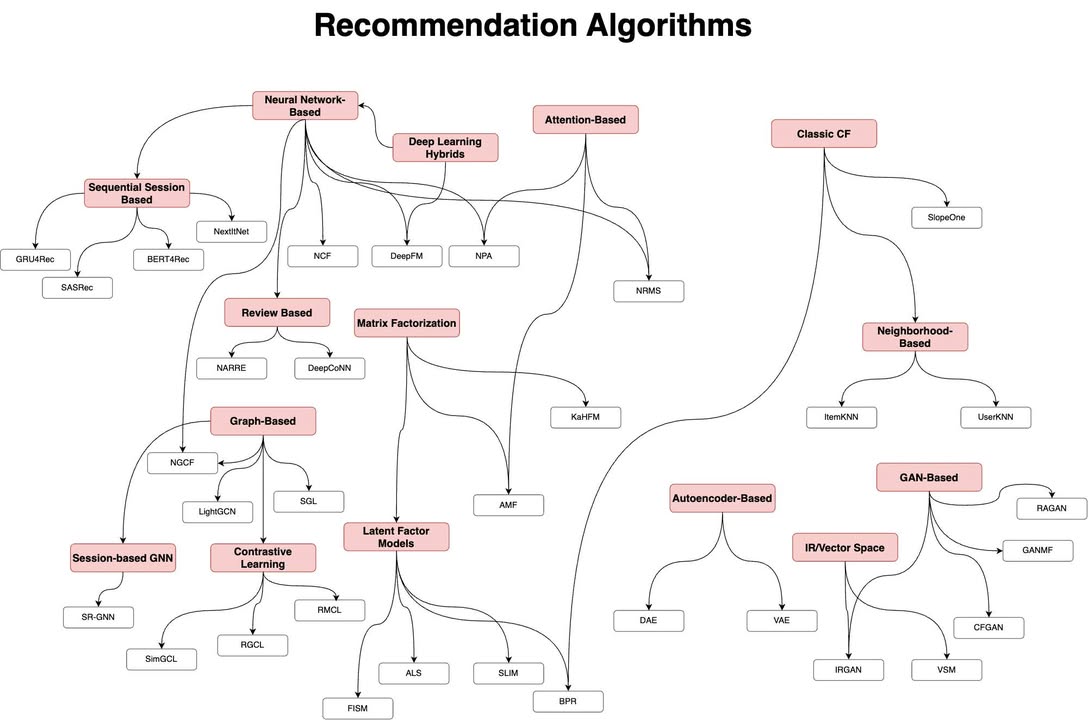

Потихоньку разбираюсь с алгоритмами рекомендаций. Это через что нетфликс или амазон рекомендует товары. Полезно понимать, раз я в области ecom работаю архитектором.

Смотрите, как мне помогают LLM — конкретно эта диаграмма была создана DeepSeek по грубому текстовому описанию — по сути, список и мои неточные размышления как наверное пункты должны быть соединены, но я просил не воспринимать это как приказ. Ну да, после получения результата я немного раскидал красиво квадратики, но связи и группировку сделал DeepSeek, и сделал лучше, чем я закидывал текстом. Выдал мне XML, который я импортировал в Draw IO. Ну я немного подвигал для красоты блоки. ChatGPT o3 с первоначальной генерацией почему-то не справился.

Затем я отправлял несколько раз эту схему на валидацию ChatGPT o1, и он по мелочам ее посоветовал подправить. То есть, ChatGPT вполне надежно понимает что с чем соединено на растровой схеме, не ошибся ни разу.

Если что, на сегодняшний день я разобрался хорошо пока только с тремя из этого списка — в дополнение к ItemKNN, UserKNN, которые тривиальные. Вот сегодня копался с ALS из блока Latent Factor Models группы Matrix Factorization. Конечно, не собираюсь в каждом разбираться, но полезно понимать хотя бы блоки и что есть что.

Если, как мы, научить пса проситься на улицу тем, что он лапой стучится в окно, а просить еду тем, что он лапой стучит по холодильнику, то быстро замечаешь интересный эффект. Игнорировать эти просьбы неприятно: не потому, что срочно надо идти гулять или кормить, а потому что стук превращается в нечто большее — в голос, а вот научить пса понимать причину отказа гораздо сложнее. Вроде как хочется и подкрепить — молодец, пойдем, сделаю что ты хочешь, ты научился с нами разговаривать, мы научились тебя понимать, а с другой стороны, собака начинает управлять тобой, понимая, что стук лапой реально дает вполне осязаемый эффект.

Собственно проблема в том, что если я не реагирую, мой пес не подумает: «А, наверное, сейчас не время». Он решит, что просто недостаточно громко или недостаточно настойчиво бьёт лапой. В его мире отсутствие ответа — это не аргумент, а повод усилить напор.

Ну хорошо, все-таки отказ словами он научился понимать и принимать. Но периодически это не работает. Видимо, в его мире недостаточно обоснованный отказ — не отказ.

Мы когда смотрим кино, к вину нарезаем сыр ломтиками. Юка знает, что когда включается проектор, то сейчас будет запах вина, а с ним обязательно приедет сыр, и устраивается рядом. И вот интересно, что он очень хорошо сечет, что сыр закончился. Он не видит, что он закончился, но, видимо, обоняние заменяет зрение. И как только доедаешь с ним последний кусок, он сам встает и уходит.

. Интересные работы. Московский художник Константин Селезнёв (1975). Некоторые немного ностальгические, да и в принципе советский реализм никуда не делся. Все-таки хороший художник должен быть еще и хорошим фотографом. Если рисуешь картины, где миллион точек фокуса и не поймешь, что главное, а что второстепенное…. Мол, все главное, рассматривайте. Не знаю, сложные чувства, но в целом больше нравится, чем не нравится. Так что делюсь.

Подобные посты группируются по тегу #artrauflikes, а на beinginamerica.com в разделе «Art Rauf Likes» есть все 146 (в отличие от Facebook, который забывает (забивает) на почти половину).

Сегодня выпало много снега, и я обратил внимание на то, что Юки оставляет очень забавные следы. 2-1-2-1-2-1. То есть, одна из лап попадает в след другой очень точно. Наверное, ничего особенного, но забавно.